인공지능

[모두의 딥러닝] lec 02. Linear Regression의 Hypothesis와 cost 설명

Predicting exam score: regression

- 학습: training

- 학습 데이터: training data

Regression (Data)

- Y: 예측하려는 대상

- X: 예측하기 위해 필요한 자료

(Linear) Hypothesis

: linear한 모델이 우리의 가설에 맞을 것이다라고 하는 것

Ex) 운동을 많이 할수록 기록이 좋아짐.

- 어떤 데이터가 있다면 여기에 잘 맞는 linear한 선을 찾는 것.

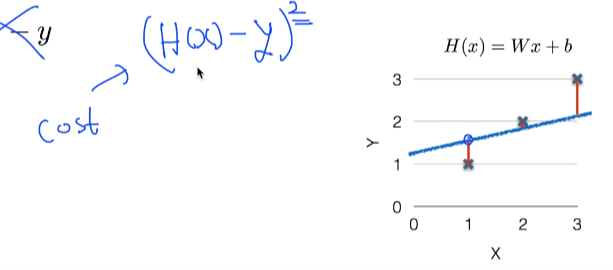

1) H(x) = Wx+b

- Which hypothesis is better?

--> H(x) = Wx+b 를 통해 파악!!

Ex) 노랑: H(x) = 0.5x+2 / 파랑: H(x) = 1x+0

- 어떤 모델이 좋은가할 떄 실제 데이터와 가설이 나타내는 점들과 비교하여

가까우면 좋은 것, 멀면 나쁜 것으로 판단.

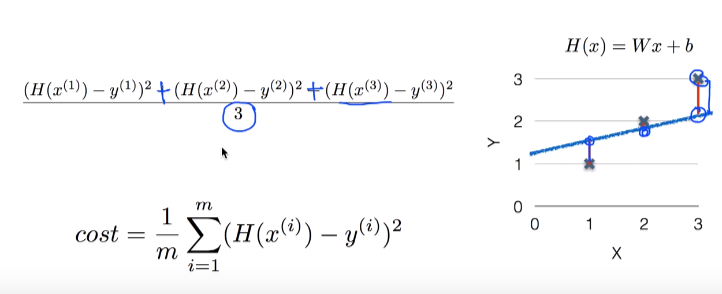

Cost function (Loss function)

- How fit the line to our (training) data

- 가장 작은 W, b를 가지게 하는 것이 Linear Regression의 학습.

'인공지능' 카테고리의 다른 글

| [모두의 딥러닝] lab 03. Minimizing Cost (0) | 2019.04.03 |

|---|---|

| [모두의 딥러닝] lec 03. Linear Regression의 cost 최소화 알고리즘의 원리 설명 (0) | 2019.04.03 |

| [모두의 딥러닝] lab 02. Linear Regression (0) | 2019.04.03 |

| [모두의 딥러닝] lab 01. TensorFlow basic (0) | 2019.04.03 |

| [모두의 딥러닝] lec 01. 기본적인 ML 용어와 개념 설명 (0) | 2019.04.01 |

댓글