[모두의 딥러닝] lab 07-1. training/test data set, learning rate, normalization

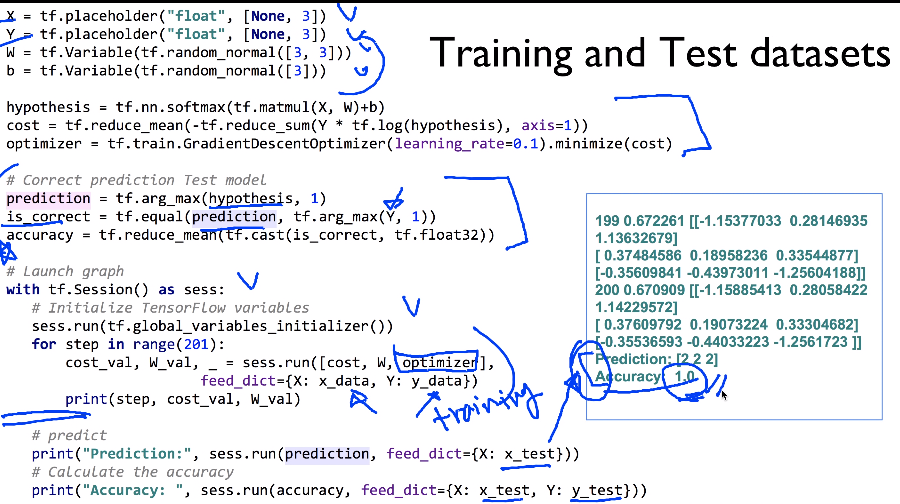

Training and Test datasets

우리가 가지고 있는 data set을 반드시 training과 test set으로 나눈다는 것 (중요)

- Training set은 학습에만 사용

- 완료 후, model이 한 번도 본 적 없는 test set으로 평가

- placeholder: 어떤 값을 던지냐에 따라 training OR test set으로 학습해볼 수 있음.

Learning rate: NaN!

- learning rate이 좋은 값으로 설정되지 않았을 때 생기는 2가지 문제점

1. Large learning rate: Overshooting

2. Small learning rate: Many iterations until convergence and trapping in local minima.

- Big learning rate

nan = learning rate이 너무 큰 게 아닐까 의심해보기

- Small learning rate

수백 번을 했는 데도 cost가 비슷하다.

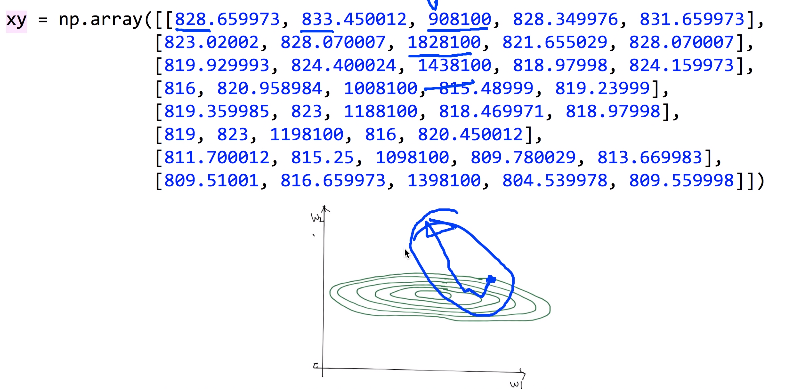

Non-normalized inputs (NaN): 데이터가 normalized되지 않았을 때

X, Y를 간단 linear regression으로 만들어서 예측해볼 것

결과 -->

해결법: Normalized inputs (min-max scale)

- MinMaxScaler() 함수

min, max를 0과 1로 준 다음 이 사이로 normalize한다.

--> 이런 모양이 되면 한번만 가더라도 밖으로 튕겨나가지 않을 것이다.

작은 learning rate을 사용하여 다시 실행 결과

'인공지능' 카테고리의 다른 글

| [모두의 딥러닝] lec 08-1. 딥러닝의 기본 개념: 시작과 XOR 문제 (0) | 2019.05.05 |

|---|---|

| [모두의 딥러닝] lab 07-2. Meet MNIST data set (0) | 2019.05.05 |

| [모두의 딥러닝] lec 07-2. Application & Tips: Training / Testing data sets (0) | 2019.05.03 |

| [모두의 딥러닝] lec 07-1. Application & Tips: 학습 rate, Overfitting, 그리고 일반화 (Regularization) (0) | 2019.05.03 |

| [모두의 딥러닝] lab 06-2. TensorFlow로 Fancy Softmax Classification 구현하기 (0) | 2019.05.03 |

댓글